咨询题1老手站长总以为robots.txt是万能开关,后果踩坑了

我们刚开端建站的时分啊,看到robots.txt那个名字就以为是个开关,觉得只需写几句就能操纵搜索引擎抓取啥不抓取啥,但理想非常打脸,非常多人写完发现搜索引擎依然乱爬,或许网站被封死,搞钞票的时机全没了

不慌,我们先搞清楚robots.txt究竟干啥的,它确实是一个文本文件,通知爬虫哪些目录能够爬,哪些不克不及爬,但它不是铁布衫,好比你写了Disallow: /wp-admin/,搜索引擎能够依然能拜候,只是它会听话一点

办法1从根底构造动手

最复杂的写法确实是两行User-agent: *,Disallow: /,如此确实是通知一切爬虫,不碰我的网站,但假如你要允许拜候,就写Allow: /,留意途径要精确,好比你要放行根目录,就写Allow: /

办法2不把敏感目录漏掉

WordPress的/wp-admin/和/wp-content/plugins/这些目录必需屏蔽,否则爬虫能够抓到后台办理界面,或许插件里的敏感代码,直截了当写Disallow: /wp-admin/,Disallow: /wp-content/plugins/,如此就稳了

办法3不用通配符乱来

有人写Disallow: /s=,想屏蔽搜索页,但参数能够变更,这时分用通配符反而会出错,好比Disallow: /s=,但有些搜索引擎能够不认,稳妥的方法是直截了当写详细途径,或许用Disallow: /s=,但不加*

办法4不疏忽sitemap

假如你有sitemap.xml,必然要在robots.txt里写上Sitemap: https://你的域名/sitemap.xml,如此搜索引擎能找到地图,效率更高,不省这一步

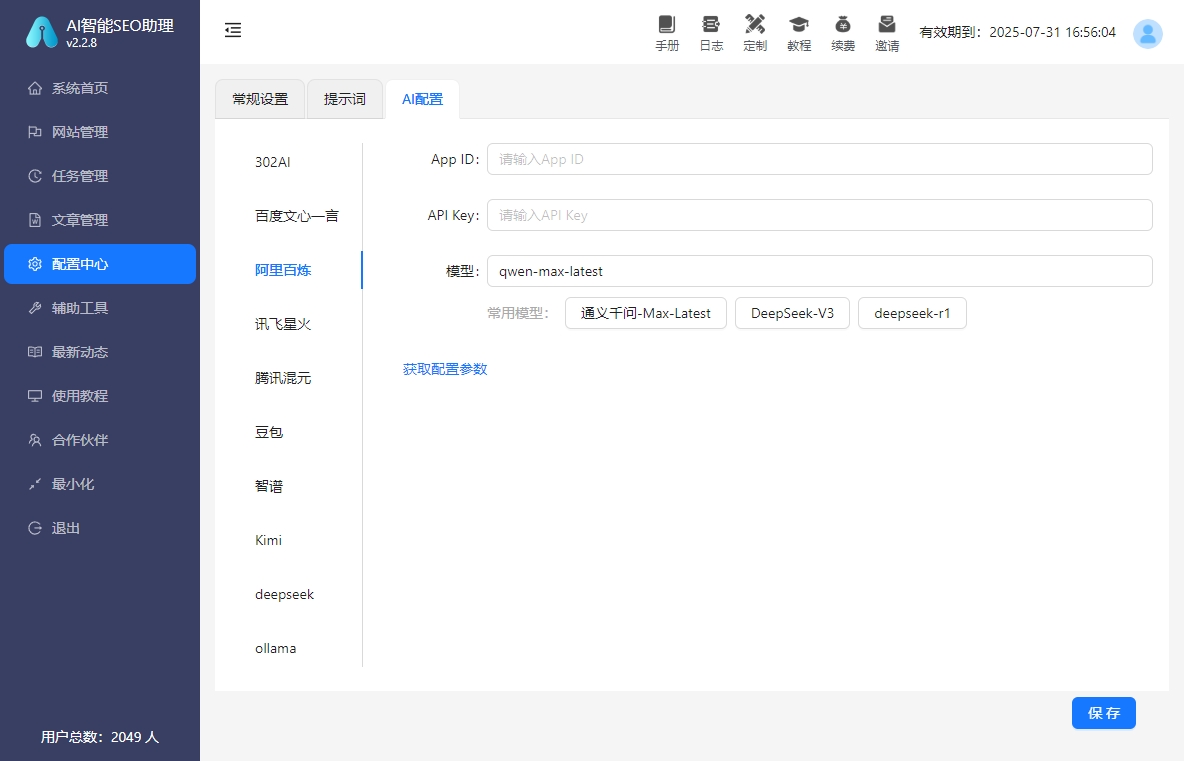

办法5不科学AI智能SEO助理

如今网上有非常多工具讲能自动生成robots.txt,但不全信,AI能够给你写一堆没用的规则,最好本身对比WordPress官方文档,或许参考老蒋部落的示例,手动调整更靠谱

咨询题2写完robots.txt发现搜索引擎不听话,咋办

你辛辛劳苦写了robots.txt,后果发现搜索引擎依然爬了不应爬的目录,或许干脆不爬了,这时分你能够会疑心人一辈子,觉得是不是本身写错了

事实上这种状况非常罕见,由于robots.txt不是强迫命令,它只是建议,有些爬虫能够不恪守,或许你的语法写错了,好比途径没写对,或许用了它不支持的参数

办法1反省途径有没有多斜杠

好比你要屏蔽/directory/那个目录,写成Disallow: /directory/,但实践途径是/directory,这时分爬虫能够不认,要么一致写带斜杠的,要么不带,不混着用

办法2不把Disallow和Allow搞反了

有些爬虫对Allow的优先级不敏感,好比你写了Disallow: /,但又写了Allow: /wp-content/uploads/,这时分能够有效,建议先写Allow再写Disallow,或许直截了当用Disallow: /,然后独自放行需求的目录

办法3用Google Search Console测试

不光看代码,去Google Search Console的robots.txt测试工具里输出你的域名,它会模仿爬虫拜候,通知你哪些规则失效,哪些没失效,如此能疾速定位咨询题

办法4不把文件放错地位

robots.txt必需放在网站根目录,好比https://你的域名/robots.txt,假如你把它丢在子目录里,搜索引擎基本找不到,直截了当生效

办法5不频繁修正文件

每次改完robots.txt,搜索引擎需求重新抓取,频繁修正能够招致缓存混乱,建议写完后察看一周,再按照数据调整,不急着折腾

咨询题3写robots.txt时纠结要不要屏蔽一切爬虫

有些老手怕费事,直截了当写User-agent: *,Disallow: /,如此一切爬虫都进不来,看起来平安,但事实上能够妨碍SEO,由于搜索引擎抓不到内容,网站就白做了

但假如你是刚建站,或许网站内容敏感,暂时不想被收录,这种写法也合理,关键看你的需求

办法1分爬虫写规则

好比你只想让Googlebot爬,写User-agent: Googlebot,Disallow:,然后User-agent: *,Disallow: /,如此Google能爬,其他爬虫不克不及爬,但要留意有些爬虫能够不认Allow

办法2不屏蔽一切爬虫

假如你的目的是做SEO,千万不写Disallow: /,不然搜索引擎抓不到内容,你的网站就白做了,建议至多放行根目录,再屏蔽敏感目录

办法3不屏蔽静态URL

有些网站有静态参数,好比id=123,假如写Disallow: /*,能够把一切带参数的页面都屏蔽了,但有些参数是需要的,好比分页,这时分得详细剖析

办法4不屏蔽sitemap目录

假如你写了Sitemap: https://你的域名/sitemap.xml,但又写了Disallow: /wp-content/,那sitemap.xml能够被屏蔽,招致搜索引擎找不到地图,记得放行sitemap.xml所在目录

办法5不疏忽法律风险

假如你屏蔽了用户协议或隐私政策页面,能够违背某些地域的法律,好比欧盟的GDPR,因此敏感页面要放行,不为了平安误伤合规性

咨询答环节

咨询什么原因robots.txt不是万能的

答由于它是建议不是命令,有些爬虫能够不恪守,或许你的语法写错了,好比途径禁绝确,或许用了不支持的参数,因此写完后必然要用工具测试

咨询假如网站被搜索引擎封死了咋办

答反省robots.txt有没有写Disallow: /,或许屏蔽了sitemap.xml,或许途径写错了,用Google Search Console的抓取形态功用检查错误,再调整规则

咨询robots.txt和noindex元标签的区不是啥

答robots.txt是通知爬虫不爬,但页面能够还在搜索后果中显示,而noindex是通知搜索引擎不收录,页面就可不能呈现在后果里,两者配合用效果更好

咨询AI智能SEO助理能帮写robots.txt吗

答能够辅佐生成,但不完全依赖,AI能够不理解你的网站构造,建议手动调整,结合工具测试,确保规则精确

如今你预备好入手了吗